Recent Posts

Link

| 일 | 월 | 화 | 수 | 목 | 금 | 토 |

|---|---|---|---|---|---|---|

| 1 | 2 | 3 | 4 | |||

| 5 | 6 | 7 | 8 | 9 | 10 | 11 |

| 12 | 13 | 14 | 15 | 16 | 17 | 18 |

| 19 | 20 | 21 | 22 | 23 | 24 | 25 |

| 26 | 27 | 28 | 29 | 30 | 31 |

Tags

- preemption #

- terminal

- JanusWebRTCGateway

- PytestPluginManager

- 헥사고날아키텍처 #육각형아키텍처 #유스케이스

- taint

- PersistenceContext

- 개성국밥

- 코루틴 빌더

- pytest

- Spring Batch

- mp4fpsmod

- table not found

- JanusWebRTC

- VARCHAR (1)

- 티스토리챌린지

- vfr video

- kotlin

- 자원부족

- JanusGateway

- JanusWebRTCServer

- tolerated

- 오블완

- 깡돼후

- python

- 겨울 부산

- 코루틴 컨텍스트

- Value too long for column

- 달인막창

- k8s #kubernetes #쿠버네티스

Archives

너와 나의 스토리

[Data Mining] Dimensionality Reduction 다차원 척도법 본문

Data Analysis/Data Mining

[Data Mining] Dimensionality Reduction 다차원 척도법

노는게제일좋아! 2020. 6. 28. 23:56반응형

개요

Data Reduction 전략

- Dimension reduction

- Wavelet transforms

- Principal Cmponents Analysis (PCA)

- Numerosity reduction

- Log-Linear Model

Fourier transform: 거리 기반의 주기 함수를 주파수 time&space 영역의 계수로 변환

Wavelet transform

- Wavelet transform은 Fourier transform의 한 가지 방법이다.

- cos과 sin을 대치하는 wavlet이라는 파형이 있다. -> cos과 sin 대신에 wavlet 사용해서 time&space 도메인의 주기 함수를 주파수 도메인의 계수로 변환

- 임의의 주기함수를 wavlet의 무한급수로 표현 가능하다.

- 시간적으로 주파수 성분이 변하는 신호에 대하여 시간과 주파수 성분을 나타내는 변환 방법.

- Wavelet Transorm이 좋은 이유?

- 두 개의 signal이 있을 때, 두 시그널의 상대 거리는 변환한 시그널의 상대 거리와 같다. 즉, 상대 거리가 보존되도록 변환할 수 있다.

- 이미지 압축에 유용하게 사용할 수 있다.

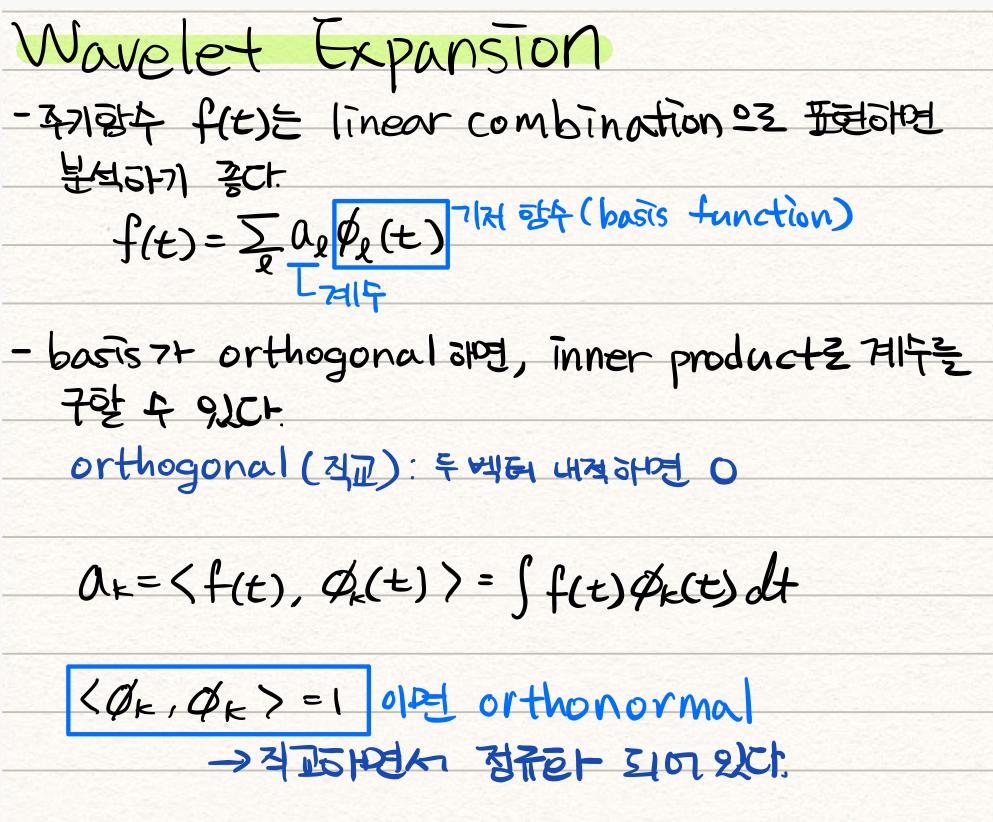

Wavelet Expansion

PCA(Principle Component Analysis)

- data의 varience가 최대가되는 방향 찾기 -> 주성분 분석

- 그 방향으로 projection!

- covarience matrix의 eigenvectors를 찾고 새로운 공간에 정의

- eigenvalue: eigenvector의 variance

- 2차원 covarience matrix에는 두 개의 주성분(eigenvector)이 나타난다.

- 각 eigenvalue는 해당 eigenvector의 variance를 나타내기 때문에 eigenvalue가 큰 eigenvector를 선택하면, 이것이 variance가 가장 큰 방향인 것이다. 이 방향으로 모든 데이터를 projection 시킨다.

- 즉, 아래 그림에서 e1 방향으로의 variance가 크기 때문에, 그 방향으로 모든 데이터를 projection 시킨다. 그러면, e2 방향의 성분은 삭제되기 때문에 "차원이 축소"된다.

- 차원이 축소되는 과정에서 정보 손실이 발생한다.

- 정보 손실을 최소화하려면 variance가 최대인 방향으로 projection을 진행해야 한다.

- variance: Covariance matrix의 diagonal

반응형

'Data Analysis > Data Mining' 카테고리의 다른 글

Comments