| 일 | 월 | 화 | 수 | 목 | 금 | 토 |

|---|---|---|---|---|---|---|

| 1 | ||||||

| 2 | 3 | 4 | 5 | 6 | 7 | 8 |

| 9 | 10 | 11 | 12 | 13 | 14 | 15 |

| 16 | 17 | 18 | 19 | 20 | 21 | 22 |

| 23 | 24 | 25 | 26 | 27 | 28 |

- JanusWebRTC

- Spring Batch

- 자원부족

- tolerated

- JanusWebRTCServer

- 헥사고날아키텍처 #육각형아키텍처 #유스케이스

- 코루틴 컨텍스트

- terminal

- 달인막창

- PersistenceContext

- Value too long for column

- preemption #

- JanusGateway

- 깡돼후

- JanusWebRTCGateway

- 티스토리챌린지

- k8s #kubernetes #쿠버네티스

- kotlin

- 오블완

- VARCHAR (1)

- 코루틴 빌더

- mp4fpsmod

- taint

- python

- 개성국밥

- pytest

- vfr video

- 겨울 부산

- table not found

- PytestPluginManager

목록Data Analysis/Machine learning (52)

너와 나의 스토리

[ML] Decision Tree - classification / regression

[ML] Decision Tree - classification / regression

Decision Tree 분류 / 회귀 작업 / 다중출력 작업이 가능한 머신러닝 알고리즘 랜덤 포레스트의 기본 구성 요소 1. Decision Tree 만들기 from sklearn.datasets import load_iris #데이터 가져옴 from sklearn.tree import DecisionTreeClassifier iris = load_iris() X = iris.data[:,2:] # 꽃잎의 길이와 너비 y = iris.target tree_clf = DecisionTreeClassifier(max_depth=2) tree_clf.fit(X,y) 2. 예측하기 새로 발견한 붓꽃의 품종을 분류해보자 * 결정 트리는 데이터 전처리가 거의 필요하지 않다. 특히 특성의 스케일을 맞추거나 평균을 ..

Training - BPTT / RTRL / EKF

Training - BPTT / RTRL / EKF

● DTRNN(Discrete-time recurrent neural network) - 네트워크가 외부 클록에 의해 구동된 것처럼 개별 단계로 처리가 수행된다 ● CTRNN(Continuous-time recurrent neural network) - 연속적인 시간에서 처리된다 Training approaches BPTT(Backpropagation though time) 스퀀스가 처리될 때마다 discrete-time RNN을 multilayer FFNN(feedforward neural network)으로 펼친다 FFNN은 시퀀스에서 각 'time step'에 대한 layer을 하나씩 가진다. 'time step'은 layer의 index와 같다 layer 간 연결을 돌려쓴다 단점: 전체 시계열을 ..

SGD / EKF / PF algorithm

SGD / EKF / PF algorithm

● SGD(Stochastic gradient descent) 배치 사이즈가 1(즉, 하나의 예)인 미니배치에서 gradient를 계산하는 것 gradient를 평가하기 위해 무작위로 선택된 샘플을 사용 반복이 충분하면 SGD는 효과 있지만 noise가 심함 first-order gradient 정보만 이용 second-order gradient 기반 기술보다 수렴이 느리고 조건이 좋지 않은 문제에서 성능이 저하된다 이를 완화시키기 위해 second-order gradient를 고려한다 수렴률(convergence rate)이 빠르고 conditioned problem에 대해 더 강력하다 Hessian Matrix라는 2차 편미분 행렬을 계산한 후 역행렬을 구해야 한다. SGD algorithm 기반의 ..

모두를 위한 딥러닝 - RNN 실습 (5)

모두를 위한 딥러닝 - RNN 실습 (5)

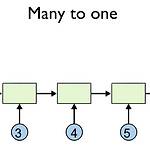

모두를 위한 딥러닝 ML lab12-6: RNN with Time Series Data 강의 정리 & 코드 전체 코드: https://github.com/hunkim/DeepLearningZeroToAll/blob/master/lab-12-5-rnn_stock_prediction.py RNN으로 time series data인 주식 시장을 예측해보자 Many to one Dataset input dimension = 5 [open, high, low, volume, close] sequence = 7 [7일 동안의 데이터를 토대로 수행] output dimension = 1 [8일 째만 예측] 1. import import tensorflow as tf import numpy as np import ma..

"Efficient Online Learning Algorithms Based on LSTM Neural Networks" 논문 소개 & 개념 정리 - LSTM 기반의 online learning

"Efficient Online Learning Algorithms Based on LSTM Neural Networks" 논문 소개 & 개념 정리 - LSTM 기반의 online learning

"Efficient Online Learning Algorithms Based on LSTM Neural Networks" Tolga Ergen and Suleyman Serdar Kozat, Senior Member, IEEE Abstract 우리는 nonlinear regression을 조사하고, LSTM network 기반의 novel regression structures를 소개한다. 이 구조를 설명하기 위해 효과적인 online training 방법을 제공한다. novel LSTM 기반 구조를 훈련시키기 위해서 우리는 기본 아키텍처를 주 공간 형태로 배치하고 매우 효율적인 PF(particle filtering) 기반 업데이트를 도입한다. 우리는 또한 확률적 경사 강하(stochastic gra..

NN(Neural Network) 설명 Deep learning은 ANN(Artificial Neural Network)를 기초로 하고 있다. 퍼셉트론에서 특정 임계치를 넘어야 신경이 전달되는 것을 Sigmoid function을 이용하여, weight을 업데이트 시켜 각 노드의 최적의 weight을 찾는 방식으로 작동 된다. ANN(Artificial Neural Network) ANN 문제점 - 학습과정에서 최적의 파라미터를 찾기 어렵다 sigmoid 함수의 문제점 때문 (local minima를 global minimum으로 인식) - Overfitting 문제 - 학습 시간이 너무 느리다 은닉층 증가될 수록 연산량 급격히 증가 ANN 문제 개선 - overfitting -> initialize p..

모두를 위한 딥러닝 - RNN 실습(4)

모두를 위한 딥러닝 - RNN 실습(4)

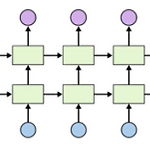

모두를 위한 딥러닝 ML lab12-4: RNN with long sequences: Stacked RNN + Softmax layer 강의 정리&코드 전체 코드: https://github.com/hunkim/DeepLearningZeroToAll/blob/master/lab-12-3-char-seq-softmax-only.py RNN의 핵심 - Wide & Deep 1. MultiRNNCell MultiRNNCell을 이용해서 cell을 쌓아보자 원하는 만큼 많이 쌓을 수 있음 cell = rnn.MultiRNNCell([cell] * 2 , state_is_tuple=True) # [cell]* n에서 n: 몇 개 쌓을 것인가 * states 변수는 층마다 하나의 텐서가 들어 있는 튜플이다. (셀의..

모두를 위한 딥러닝 - RNN 실습(3)

모두를 위한 딥러닝 - RNN 실습(3)

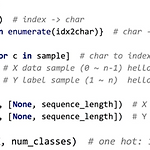

모두를 위한 딥러닝 ML lab12-3: Long Sequence RNN 강의 정리&코드 전체 코드: https://github.com/hunkim/DeepLearningZeroToAll/blob/master/lab-12-2-char-seq-rnn.py 1. data creation # Data creation idx2char = ['h', 'i', 'e', 'l', 'o'] # Teach hello: hihell -> ihello x_data = [[0, 1, 0, 2, 3, 3]] # hihell x_one_hot = [[[1, 0, 0, 0, 0], # h 0 [0, 1, 0, 0, 0], # i 1 [1, 0, 0, 0, 0], # h 0 [0, 0, 1, 0, 0], # e 2 [0, 0, 0,..